robots文件是指網站與搜索引擎之間的協議,同時也是蜘蛛爬行網站時訪問的第一個文件。當蜘蛛訪問某個網站時,它首先會先檢查該網站的根目錄上是否有robots文件,如果有的話,蜘蛛就會按照文件中的內容來確定訪問的范圍,如果沒有的話,蜘蛛就會漫無目的地訪問網站中的所有頁面。

robots文件的作用

- 可以屏蔽網站中的死鏈。制作robots文件可以避免蜘蛛訪問網站中可能存在的無法打開的鏈接,也就是死鏈。

- 可以避免蜘蛛訪問網站內的重復內容和重復頁面。

- 阻止蜘蛛前來訪問網站中的隱私性內容。

- 幫助蜘蛛來到我們想要被訪問的內容,提升爬取速度。

robots文件如何制作?

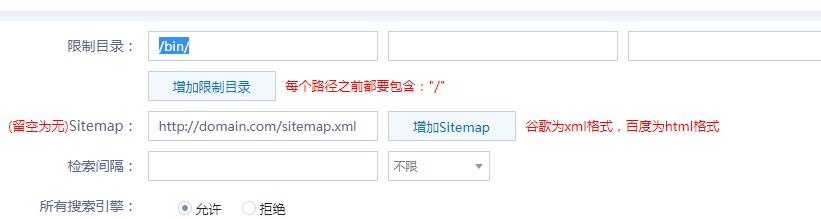

我們可以利用站長工具進行操作:

打開站長工具平臺

根據網站的需要可以進行格式的更改。

修改完成后就可以進行保存:創建記事本—然后為robots.txt—通過FTP上傳到根目錄即可。

網站沒有robots文件的弊端:

如果網站中沒有robots.txt文件,則網站中一些無關、重復的內容也會被搜索引擎爬取,并且也不會增加網站的收錄,更不會提升權重,可能還會導致網站的重要內容卻沒有被訪問。

其實,robots文件看起來制作非常簡單,但稍不注意,就可能出現錯誤,可能就會導致網站一直沒有被收錄。甚至還有很多小伙伴認為robots文件并不重要,覺得可有可無,這種想法也是非常錯誤的,因此,我們在進行優化工作時,一定要認識到robots文件的重要性。它是我們做SEO不可或缺的步驟。